FastAPI部署模型,高效、便捷的模型应用实现

摘要:,,FastAPI是一种高效、便捷的模型应用实现工具,可以快速部署模型。它支持使用Python编写API,并提供了强大的路由和中间件功能,使得模型应用开发变得更加简单和快速。通过FastAPI,开发者可以轻松地构建出高性能、可扩展的Web API,实现模型的高效应用。使用FastAPI部署模型,不仅可以提高开发效率,还可以降低开发成本,为模型应用提供更好的支持和保障。

在当今的互联网时代,模型的应用已经深入到各个领域,无论是机器学习、深度学习还是传统的数据分析,模型的部署和运用都显得尤为重要,而如何高效、便捷地部署模型,使其能够在生产环境中稳定运行,成为了众多开发者关注的焦点,本文将介绍如何使用FastAPI进行模型部署,以及其带来的优势和注意事项。

FastAPI简介

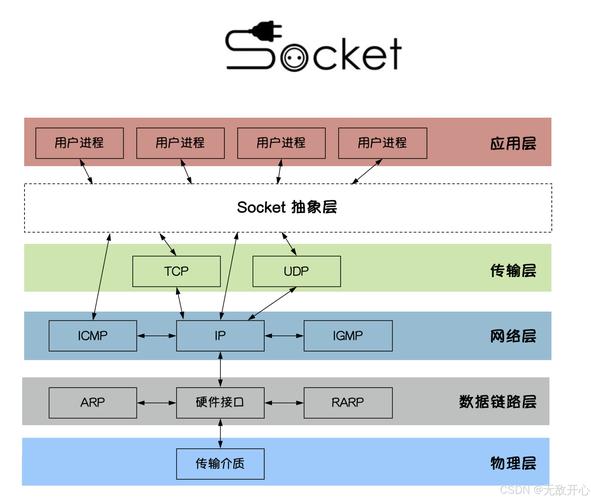

FastAPI是一个用于构建API的现代、快速(高性能)的Web框架,基于标准Python类型提示,它提供了快速路由和实时自动文档等功能,使得开发者可以轻松地构建出高性能、高可用性的Web服务,在模型部署方面,FastAPI可以很好地与各种机器学习框架(如TensorFlow、PyTorch等)进行集成,为模型的快速部署提供了强有力的支持。

FastAPI部署模型的步骤

1、准备模型和代码

需要准备好要部署的模型以及相关的代码,这些代码应该能够将模型转化为可调用的函数或类,以便在FastAPI中进行调用。

2、安装FastAPI及相关依赖

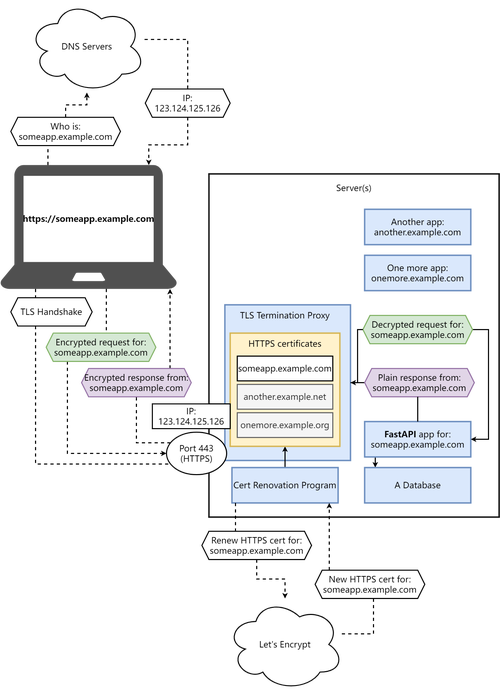

在部署环境中安装FastAPI及相关依赖,如uvicorn(FastAPI的ASGI服务器)。

3、编写FastAPI代码

根据模型的特性和需求,编写FastAPI代码,这包括定义路由、参数、请求和响应等,需要利用Python的类型提示功能,为模型提供清晰的输入和输出类型。

4、集成模型

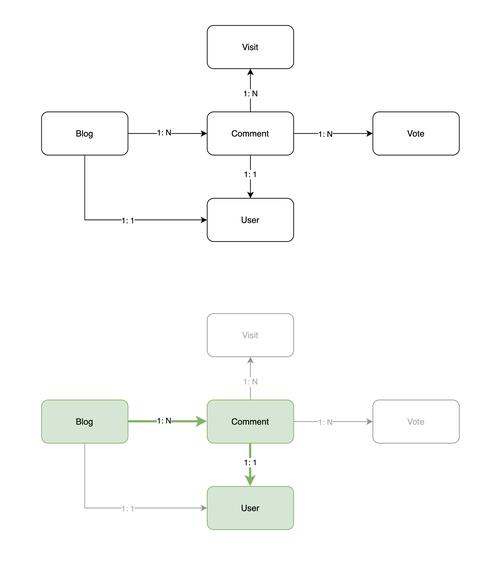

将模型代码集成到FastAPI应用中,使其能够在路由处理函数中被调用,这一步需要确保模型能够正确地接收输入数据,并返回预期的输出结果。

5、运行和测试

运行FastAPI应用,并进行测试,确保模型能够在生产环境中稳定运行,并满足业务需求。

6、文档生成

利用FastAPI的自动文档功能,生成API文档,这有助于其他开发者了解和使用你的API接口。

FastAPI部署模型的优势

1、高性能:FastAPI基于标准Python类型提示,具有高性能的特点,在模型部署方面,可以确保API接口的响应速度和吞吐量。

2、便捷开发:FastAPI提供了丰富的功能和工具,使得开发者可以快速地构建出高性能、高可用性的Web服务,其简单的语法和易读的代码结构也降低了开发难度。

3、易于集成:FastAPI可以很好地与各种机器学习框架进行集成,使得模型的部署变得更加简单和便捷。

4、自动文档:FastAPI提供了自动文档功能,可以轻松地生成API文档,有助于其他开发者了解和使用你的API接口。

5、社区支持:FastAPI拥有庞大的社区支持,可以获得来自全球开发者的帮助和支持。

注意事项

1、模型优化:在部署模型之前,需要对模型进行优化,以提高其性能和响应速度,这包括对模型的参数进行调整、对输入数据进行预处理等。

2、安全性:在部署模型时,需要考虑安全性问题,对输入数据进行验证和过滤,防止恶意攻击和数据泄露等。

3、监控和维护:在生产环境中,需要对API接口进行监控和维护,这包括监控接口的响应时间、错误率等指标,并及时处理问题和修复bug。

使用FastAPI进行模型部署是一种高效、便捷的实现方式,它具有高性能、易开发、易集成等优势,可以为模型的稳定运行提供强有力的支持。