FastAPI部署大模型并发性能的优化实践

摘要:,,本文介绍了FastAPI部署大模型并发性能的优化实践。通过使用异步编程和并行处理技术,可以显著提高FastAPI的并发性能。针对大模型部署,建议采用分布式架构和负载均衡策略,以充分利用多台服务器资源,提高系统整体性能。优化模型参数、使用高性能硬件和优化网络传输等措施也能有效提升FastAPI的并发性能。通过这些实践,可以更好地满足大模型并发处理的需求,提高系统的稳定性和响应速度。,,,,本文通过介绍FastAPI部署大模型并发性能的优化实践,提供了提高系统性能的有效方法。通过异步编程、分布式架构、负载均衡、模型参数优化、高性能硬件和网络传输优化等措施,可以显著提升FastAPI的并发性能,满足大模型并发处理的需求。这些实践对于提高系统的稳定性和响应速度具有重要意义。

随着人工智能技术的不断发展,大模型的训练和部署成为了许多企业和研究机构的重要任务,大模型的部署往往面临着并发性能的挑战,本文将探讨如何使用FastAPI框架来部署大模型,并针对并发性能进行优化。

FastAPI框架简介

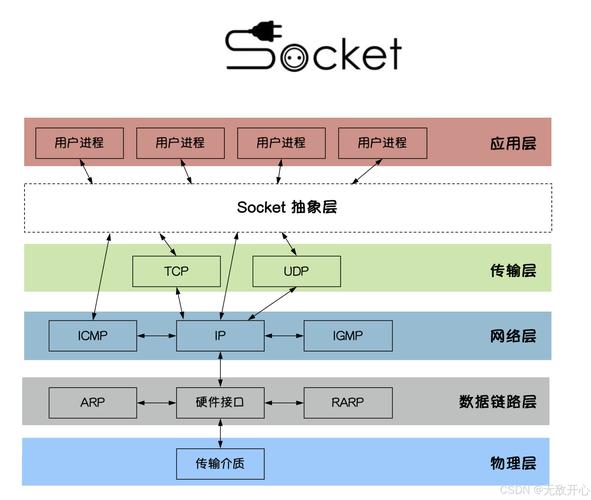

FastAPI是一个用于构建API的现代、快速(高性能)的Web框架,基于标准Python类型提示实现自动文档生成和交互式API,它支持异步编程,具有低延迟、高并发等优点,非常适合用于部署大模型。

大模型部署的挑战

在部署大模型时,我们通常会面临以下几个挑战:

1、计算资源需求大:大模型通常需要大量的计算资源,如CPU、GPU和内存等。

2、并发性能要求高:为了满足实时响应的需求,大模型的部署系统需要具备高并发性能。

3、模型加载和推理速度快:为了提升用户体验,模型加载和推理的速度也是非常重要的。

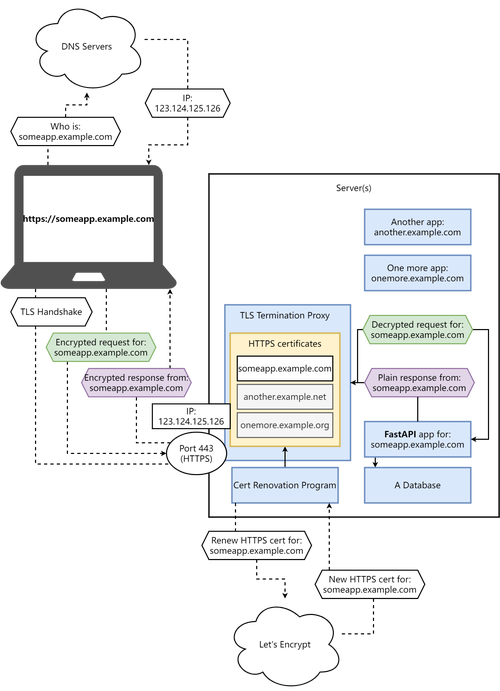

FastAPI部署大模型的方案

针对以上挑战,我们可以使用FastAPI框架来部署大模型,具体方案如下:

1、选择合适的后端服务:FastAPI支持异步编程,可以与各种后端服务(如Dask、Ray等)进行集成,以满足大模型的计算需求。

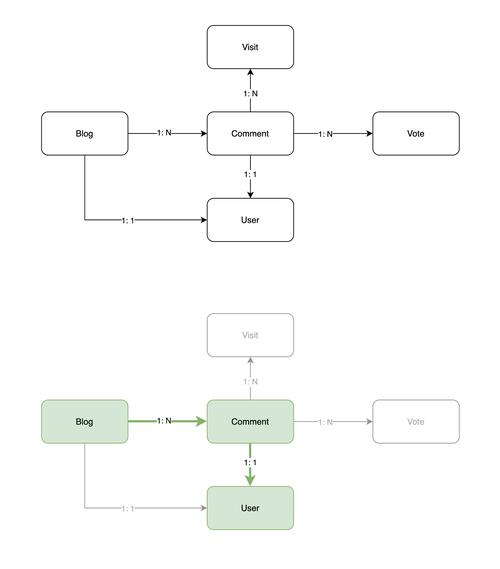

2、模型集成与封装:将大模型集成到FastAPI应用中,通过API接口对外提供服务,为了提高模型的加载和推理速度,可以对模型进行优化和封装。

3、性能优化:针对并发性能的要求,我们可以采取以下措施:

a) 使用异步编程:FastAPI支持异步编程,可以充分利用异步IO的特性,提高系统的并发性能。

b) 优化数据库连接:如果大模型需要使用数据库存储数据,可以优化数据库连接,减少数据库访问的延迟。

c) 负载均衡:通过负载均衡技术,将请求分发到多个服务器上处理,提高系统的并发处理能力。

d) 缓存机制:对于频繁访问的数据和模型结果,可以使用缓存机制进行存储和复用,减少计算资源的消耗。

并发性能的优化实践

在FastAPI部署大模型的并发性能优化实践中,我们可以采取以下措施:

1、代码优化:对FastAPI应用的代码进行优化,减少不必要的计算和内存消耗,使用更高效的算法和数据结构,避免重复计算等。

2、资源分配与调度:根据大模型的计算需求和系统的资源情况,合理分配计算资源,可以使用分布式计算框架(如Dask、Ray等)来扩展计算能力。

3、监控与调优:对系统的性能进行监控和调优,可以使用性能分析工具(如Profiler、Trace等)来分析系统的瓶颈和性能瓶颈所在的位置,然后进行针对性的优化。

4、扩展性设计:在系统设计时考虑扩展性,以便在未来需要扩展计算资源时能够方便地进行扩展,可以使用微服务架构来设计系统,将不同的功能模块拆分成独立的微服务,以便于扩展和维护。

本文介绍了如何使用FastAPI框架来部署大模型,并针对并发性能进行了优化,通过选择合适的后端服务、模型集成与封装、性能优化等措施,可以提高大模型的并发性能和响应速度,在实际应用中,我们需要根据具体的需求和场景来选择合适的方案和技术手段。