Flask框架中封装PyTorch模型的应用实践

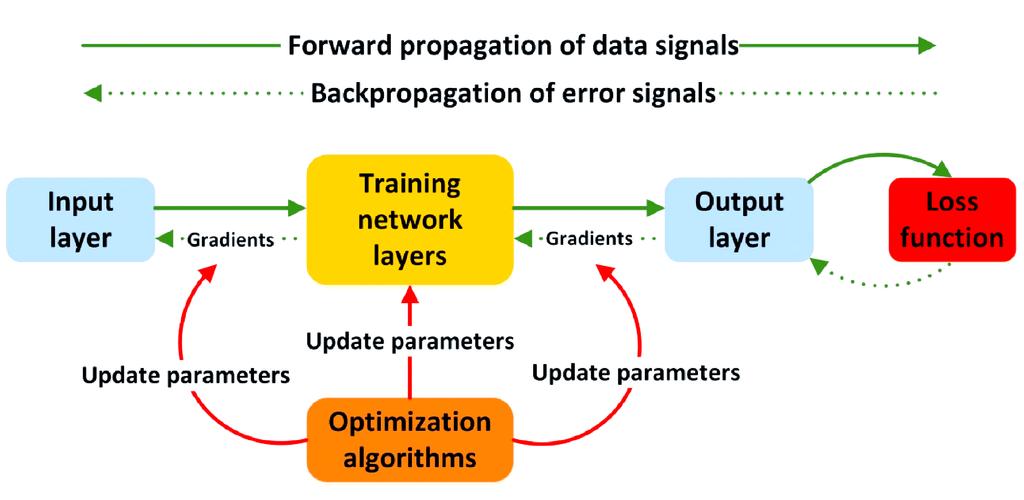

摘要:,,在Flask框架中封装PyTorch模型的应用实践,主要涉及模型训练、保存和部署等步骤。使用PyTorch进行模型训练和优化,将训练好的模型保存为Torch格式文件。在Flask框架中创建Web应用,通过导入PyTorch模型并封装成API接口,实现模型的在线预测和部署。此过程中需要注意模型文件路径、API接口设计、数据传输格式等问题。通过实践应用,可以有效地将深度学习模型集成到Web应用中,提高应用性能和用户体验。

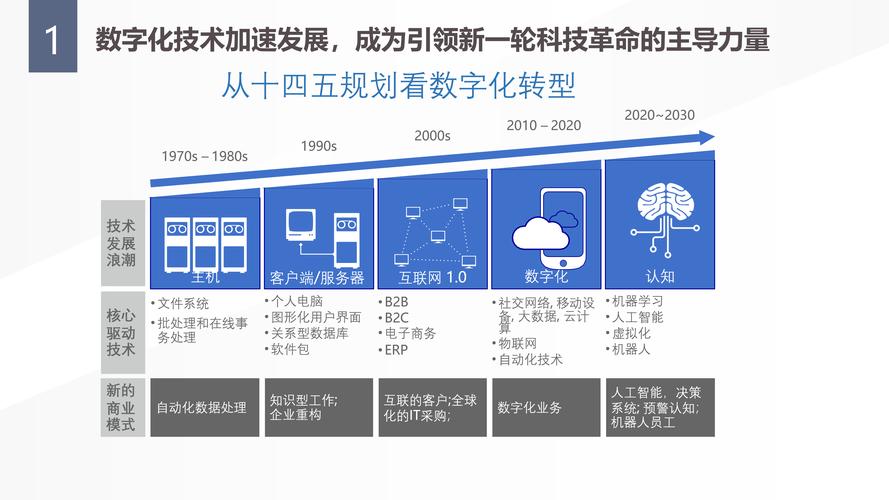

随着深度学习技术的不断发展,PyTorch作为一款开源的深度学习框架,在学术界和工业界都得到了广泛的应用,如何将训练好的PyTorch模型集成到Web应用中,以便于用户进行在线使用和部署,成为了一个亟待解决的问题,Flask作为一个轻量级的Web应用框架,具有简单、快速、灵活等优点,因此成为了集成PyTorch模型的首选框架之一,本文将介绍如何在Flask框架中封装PyTorch模型,以便于实现Web应用的快速部署和在线使用。

Flask框架简介

Flask是一个轻量级的Web应用框架,采用Python语言编写,它提供了路由、模板、会话管理等基本功能,同时也支持集成各种扩展模块,如数据库操作、表单处理等,Flask具有简单、快速、灵活等优点,因此被广泛应用于Web应用的开发中。

PyTorch模型简介

PyTorch是一个开源的深度学习框架,具有强大的计算能力和灵活的编程接口,它支持多种深度学习算法和模型结构,包括卷积神经网络、循环神经网络、生成对抗网络等,通过PyTorch,我们可以轻松地训练和部署各种深度学习模型。

Flask封装PyTorch模型的步骤

1、准备环境

首先需要安装Flask和PyTorch相关的库和工具,可以通过pip命令进行安装,如:pip install flask torch,还需要准备好要集成的PyTorch模型和相关代码。

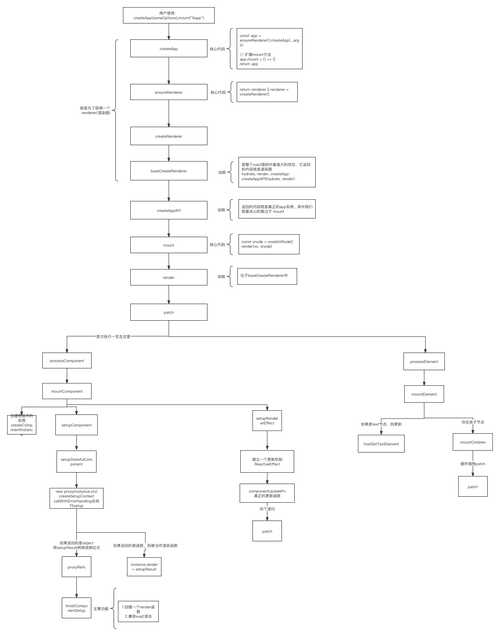

2、创建Flask应用

使用Flask框架创建一个Web应用,并定义路由、模板等基本功能,可以创建一个名为app.py的文件,并定义一个Flask实例:

from flask import Flask, request, jsonify app = Flask(__name__)

3、加载PyTorch模型

将训练好的PyTorch模型加载到Flask应用中,可以使用PyTorch提供的加载模型的方法,如torch.load(),将模型加载到内存中,需要定义一些处理模型的函数和方法。

4、定义路由和处理函数

在Flask应用中定义路由和处理函数,以便于用户通过HTTP请求访问模型并进行计算,可以定义一个POST请求的路由/predict,用于接收用户上传的数据并返回预测结果,在处理函数中,可以使用PyTorch模型对数据进行计算,并返回计算结果。

@app.route('/predict', methods=['POST'])

def predict():

data = request.json # 获取用户上传的数据

# 使用PyTorch模型进行计算

result = model.forward(data) # 假设model为已加载的PyTorch模型实例

return jsonify(result) # 返回计算结果5、运行Flask应用

运行Flask应用,并监听指定的端口号,可以运行app.run(port=8080)来启动Flask应用并监听8080端口,用户可以通过浏览器或API工具访问该端口号进行模型的在线使用和部署。

注意事项和优化建议

1、安全性:在集成PyTorch模型时,需要注意安全问题,需要对上传的数据进行验证和过滤,防止恶意攻击和数据泄露等问题,也需要对用户的权限进行控制和管理,确保只有授权用户才能访问模型和进行计算。

2、性能优化:在集成PyTorch模型时,需要考虑性能问题,可以通过优化模型的计算过程、使用GPU加速等方式来提高模型的计算速度和响应时间,也可以对Flask应用进行性能优化,如使用缓存、压缩等技术来提高应用的性能和响应速度。

3、文档和测试:在集成PyTorch模型后,需要编写相应的文档和测试用例,以便于用户了解和使用模型,也需要对模型进行测试和验证,确保模型的准确性和可靠性。

4、扩展性:在Flask框架中集成PyTorch模型时,需要考虑扩展性问题,可以通过使用Flask的扩展模块、插件等方式来扩展应用的功能和性能,也需要考虑模型的升级和维护问题,以便于在后续的开发和维护中方便地进行模型的升级和维护工作。

本文介绍了如何在Flask框架中封装PyTorch模型,以便于实现Web应用的快速部署和在线使用,通过准备环境、创建Flask应用、加载PyTorch模型、定义路由和处理函数等步骤,可以轻松地将训练好的PyTorch模型集成到Web应用中,也需要注意安全问题、性能优化、文档和测试等问题,以确保应用的稳定性和可靠性,通过本文的介绍和实践,相信读者可以更好地掌握Flask框架中集成PyTorch模型的方法和技巧,