Kafka与Spring Boot的完美结合,配置指南

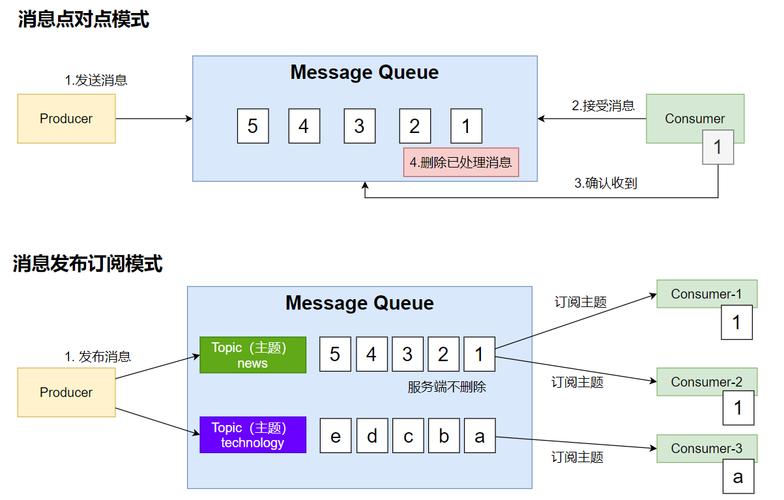

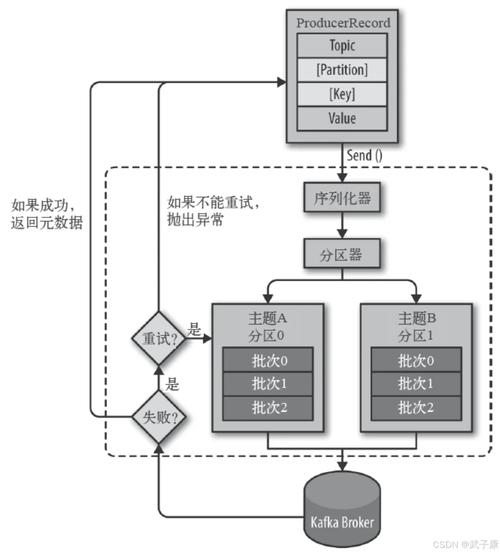

Kafka与Spring Boot的完美结合,可以实现高效、可靠的实时数据处理。配置指南包括:设置Kafka生产者和消费者的基本配置,如主题、分区数等;配置Spring Boot与Kafka的连接,包括序列化器和反序列化器的选择;实现Spring Boot中Kafka的监听和发送消息的代码。通过这样的结合,可以轻松地集成Kafka到Spring Boot应用中,提高系统的可扩展性和可维护性。

在当今的微服务架构和事件驱动型应用中,Apache Kafka和Spring Boot是两个不可或缺的组件,Kafka作为一款开源的分布式流处理平台,能够处理大量的实时数据,而Spring Boot则以其简洁、快速的开发体验为开发者所喜爱,本文将详细介绍如何在Spring Boot项目中集成Kafka,并给出具体的配置指南。

(图片来源网络,如有侵权,联系邮箱xiajin@b31.cn马上删谢谢!)

准备工作

在开始配置之前,需要确保已经安装了Kafka和Spring Boot的相关依赖,对于Kafka,需要安装其服务器端软件,并确保其正常运行,对于Spring Boot,需要使用Maven或Gradle等构建工具,并在项目中添加相应的依赖。

三、Spring Boot项目中的Kafka配置

(图片来源网络,如有侵权,联系邮箱xiajin@b31.cn马上删谢谢!)

1、添加依赖

在Spring Boot项目的pom.xml文件中,添加Kafka的依赖。

(图片来源网络,如有侵权,联系邮箱xiajin@b31.cn马上删谢谢!)

<dependency>

<groupId>org.springframework.kafka</groupId>

<artifactId>spring-kafka</artifactId>

<version>您的Kafka版本号</version>

</dependency>请根据实际情况替换版本号。

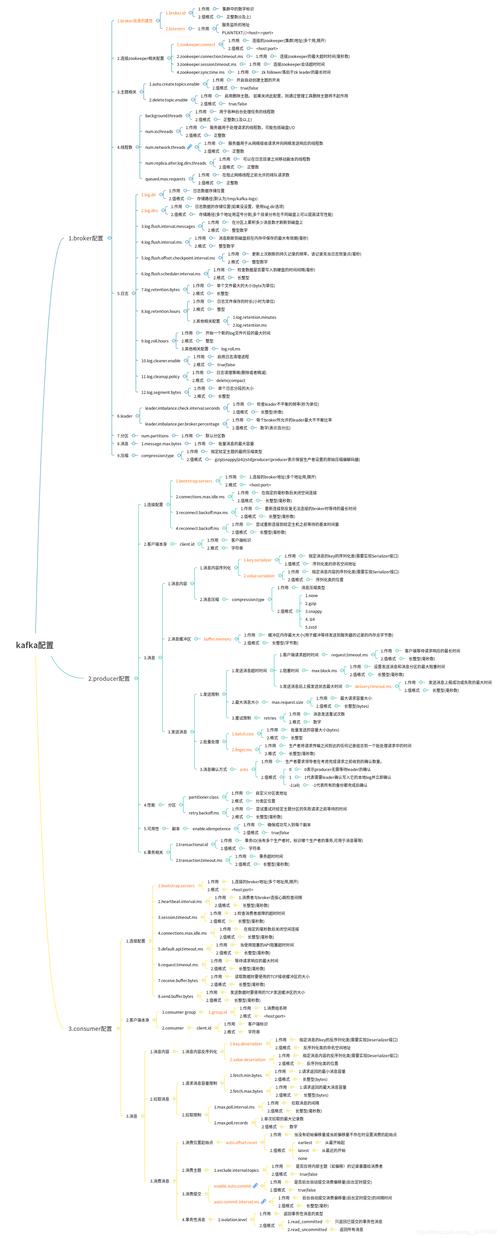

2、配置文件

在application.properties或application.yml文件中,配置Kafka的相关参数,主要包括Kafka服务器的地址、端口、生产者和消费者的相关配置等。

application.properties文件配置示例:

spring.kafka.bootstrap-servers=localhost:9092 spring.kafka.consumer.group-id=my-group-id spring.kafka.consumer.auto-offset-reset=earliest spring.kafka.producer.key-serializer=org.apache.kafka.common.serialization.StringSerializer spring.kafka.producer.value-serializer=org.springframework.kafka.support.serializer.JsonSerializer

application.yml文件配置示例:

spring:

kafka:

bootstrap-servers: localhost:9092

consumer:

group-id: my-group-id

auto-offset-reset: earliest

producer:

key-serializer: org.apache.kafka.common.serialization.StringSerializer

value-serializer: org.springframework.kafka.support.serializer.JsonSerializer3、生产者配置

在Spring Boot项目中,可以使用@KafkaProducer注解来配置生产者。

@Bean("kafkaProducer")

public KafkaProducer<String, String> kafkaProducer() {

Map<String, Object> configProps = new HashMap<>();

configProps.put(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG, "localhost:9092"); // Kafka服务器地址

configProps.put(ProducerConfig.KEY_SERIALIZER_CLASS_CONFIG, StringSerializer.class); // 键序列化器类名

configProps.put(ProducerConfig.VALUE_SERIALIZER_CLASS_CONFIG, JsonSerializer::new); // 值序列化器类名(这里使用Json序列化器)

return new KafkaProducer<>(configProps); // 创建生产者对象并返回,注意这里需要使用@Autowired注解注入到其他组件中。} 4 消费者配置 在Spring Boot项目中,可以使用@KafkaListener注解来配置消费者。 @KafkaListener(topics = "my-topic", groupId = "my-group-id") public void onMessage(String message) { // 处理接收到的消息 } topics参数指定要监听的Kafka主题名称,groupId参数指定消费者组ID,当有新的消息到达时,onMessage方法将被调用并处理消息。 四、测试与验证 完成以上配置后,可以启动Spring Boot项目并测试Kafka的发送和接收功能,首先启动Kafka服务器和Spring Boot项目,然后使用Kafka生产者工具或代码发送消息到指定的主题中,接着观察Spring Boot项目的控制台输出,看是否能够接收到消息并正确处理,如果一切正常,则说明Kafka与Spring Boot的集成配置成功。 五、本文介绍了如何在Spring Boot项目中集成Kafka,并给出了具体的配置指南,通过添加依赖、配置文件、生产者和消费者配置等步骤,可以轻松地将Kafka与Spring Boot结合起来,实现实时数据的处理和传输,在实际应用中,还需要根据具体需求进行相应的调整和优化,希望本文能够帮助您更好地理解和使用Kafka与Spring Boot的集成功能。

文章版权声明:除非注明,否则均为新区云原创文章,转载或复制请以超链接形式并注明出处。